Cos’è un Large Language Model e a cosa serve

- Home

- Blog

- Tecnologie emergenti e tendenze

- Cos’è un Large Language Model e a cosa serve

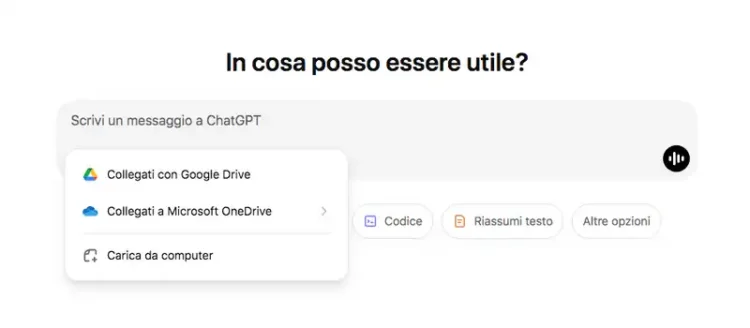

Oggi è impossibile ignorare il tema dei Large Language Model (LLM) dato che questi concetti sono alla base delle moderne evoluzioni dell’intelligenza artificiale generativa. Stiamo parlando di un modello di linguaggio che può aiutare applicazioni come ChatGPT o Google Gemini per supportare qualsiasi richiesta.

Di cosa stiamo parlando esattamente? Iniziamo da una definizione di Large Language Model. Un LLM non è altro che un modello linguistico di grandi dimensioni capace di comprendere e generare il linguaggio umano. Ciò avviene grazie all’addestramento ottenuto con una grande quantità di dati e funziona grazie a reti neurali che consentono di fare una previsione della parola o del simbolo successivo a quello generato.

Tutto questo per riconoscere in un LLM la soluzione ideale per comprendere codici umani, come input testuale o visuale che può restituire a sua volta contenuto scritto, grafico, video o audio. Ciò avviene grazie a un tipo di machine learning (deep learning) che consente di effettuare un’analisi probabilistica dei dati.

Anche con un addestramento ben strutturato, i Large Language Model sono ancora soggetti a bias e distorsioni ereditate dalle sovrastrutture del pensiero umano. Come i pregiudizi culturali, etnici e di genere.

Indice dei contenuti

Quali sono le questioni di Ai Ethics legate ai sistemi di intelligenza artificiale che includono anche i Large Language Models? I principi fondamentali che regolano queste tecnologie dovrebbero essere quelli del rispetto della privacy, la trasparenza sull’uso delle informazioni, sviluppo responsabile della tecnologia e impegno a eliminare bias, pregiudizi, costruzioni legate a informazioni ottenute durante l’addestramento.

I LLM possono riprodurre o amplificare bias presenti nei dati di addestramento, creando discriminazioni basate su genere o religione. L’AI governance dovrebbe occuparsi di queste condizioni ma non è facile.

Molto è stato fatto su questo fronte, anche se le sfide sono ancora importanti perché è possibile aggirare i filtri e i blocchi. Ad esempio, è stato riscontrato in un primo momento la possibilità di creare delle armi o degli esplosivi seguendo le istruzioni di ChatGPT. I programmatori sono intervenuti ma oggi sappiamo che la Tesla fatta esplodere davanti a un palazzo di proprietà Trump è stata modificata seguendo le istruzioni proprio di ChatGPT. Un approccio ethical AI è possibile ma c’è bisogno di molto lavoro alla base.

Abbiamo capito, in linea di massima, cos’è un Large Language Model. Ora cerchiamo di definire l’uso: a cosa serve? La lista delle possibili applicazioni dei modelli linguistici di grandi dimensioni è infinita, proviamo a dare una lista minima da avere sempre sotto stretta osservazione per implementare i software di LLM.

Il pensiero rispetto ai possibili usi dei Large Language Model va subito alla generazione di testi, che è uno dei punti di forza dei moderni chatbot AI. Con il giusto prompt puoi ottenere grandi quantità di contenuti ma guai a chi pensa di poter sostituire la tastiera di un bravo autore: fioccano errori, imprecisioni e bias.

Si tratta di un valido supporto per organizzare, definire, approfondire e correggere. D’altro canto, la semplicità con la quale puoi generare sintesi di riunioni, pitch, messaggi personalizzati per i clienti e automazione di e-mail è disarmante: con una buona rifinitura hai uno strumento eccezionale in mano.

Uno dei settori in cui i LLM possono dare una grande mano all’uomo. Pensa, ad esempio, alla possibilità di generare report approfonditi grazie a un comando: carichi un PDF, chiedi di estrapolare informazioni specifiche e generi report con impegno manuale ridotto. Puoi fare lo stesso con l’analisi del sentiment, ad esempio se hai la necessità di sintetizzare grandi quantità di recensioni dei clienti. Facciamo un esempio?

Vuoi arricchire le schede prodotto partendo dalle opinioni dei clienti? Carica un file che contiene le review – in questi casi le versioni a pagamento sono più efficaci – e chiedi di estrapolare i punti di forza che emergono con costanza. A questo punto devi solo intervenire e sai di poterlo fare con un approccio data driven.

Un buon uso dei programmi e delle app che si basano su Large Language Model: creazione di chatbot avanzati e in grado di rispondere ai potenziali clienti su e-commerce, siti web di istituti finanziari e aziende che hanno bisogno di customer care service costante, 24 ore su 24. Con queste soluzioni puoi affrontare domande frequenti, risolvere problemi e gestire richieste complesse.

Emulando conversazioni dai confini quasi umani. Il concetto di assistenza virtuale può essere elevato anche in settori più importanti per il genere umano come, ad esempio, quello della telemedicina e della chirurgia. O della sicurezza informatica grazie al rilevamento di pattern sospetti nei testi (ad esempio phishing).

Un altro traguardo raggiunto dai modelli LLM come Google Translate: tradurre in modo accurato qualsiasi tipo di contenuto mantenendo presente il contesto. Soluzioni avanzate come DeepL ti permettono di migliorare profondamente l’output con strumenti di scrittura assistita che modificano in tone of voice.

Nel presentare i Large Language Model e nel trovarne la giusta definizione abbiamo citato una serie di concetti legati a tecnologie di base per sviluppare LLM. Quali sono le più importanti? In primo luogo dobbiamo ricordare che i LLM sono basati su reti neurali profonde, tipo i Transformer che hanno il compito di elaborare grandi quantità di dati, definire l’importanza delle parole in un contesto e trovare le relazioni tra

Per dare consistenza a tutto ciò introduciamo i modelli di apprendimento automatico che possono essere supervisionato, senza supervisione e semi-supervisionato. Come operano questi sistemi? Assistiamo a una fase di Pre-Training su dati testuali importati e una di Fine Tuning per l’ottimizzazione dei dettagli.

Per migliorare l’efficienza vengono utilizzate tecniche avanzate di ottimizzazione che rendono applicazioni di natural language processing (NLP) sempre più efficaci in grado di interagire con i contenuti testuali. Ad esempio, uno dei riferimenti è proprio il Generative Pre-trained Transformer, un modello di linguaggio (Large Language Model, LLM) introdotto da OpenAI e che ha fatto da base proprio per il classico ChatGPT.

Tutto cambia con una velocità unica. Ogni mese si susseguono novità che permettono di introdurre nuove funzionalità e orizzonti di sviluppo. Le tecnologie emergenti nel campo dei Large Language Models (LLM) determinano il futuro dell’intelligenza artificiale, migliorandone efficienza e sostenibilità. Come avviene con gli algoritmi di clustering che permettono di organizzare grandi quantità di dati non strutturati.

Ad esempio, c’è da considerare il federated learning che tutela uno degli aspetti fondamentali dell’AI Ethics: la privacy. Infatti, questa tecnica di apprendimento automatico consente di addestrare modelli LLM in modo distribuito, usando i dati presenti su dispositivi locali senza trasferimento su un server centrale.

Per risparmiare tempo e risorse abbiamo lo sviluppo delle tecniche di transfer learning, una tecnica di machine learning in cui un modello già addestrato su alcune attività viene ridefinito per essere utile su un lavoro correlato. Sempre nello stesso contesto troviamo il machine learning automatizzato (AutoML), che riduce il contributo umano introducendo tecniche di automazione per selezionare, configurare e ottimizzare i parametri, le architetture e i processi di addestramento

C’è da considerare anche la grande evoluzione che c’è stata in termini di linguistica computazionale nel contesto dei Large Language Models (LLM) per migliorare la comprensione e la generazione di un risultato naturale da parte delle macchine. Questo avviene integrando conoscenze linguistiche con capacità di apprendimento automatico, e sicuramente avrai notato che gli output di ChatGPT sono sempre più vicini a un testo che avresti potuto scrivere personalmente.

Affrontiamo le evoluzioni delle reti neurali convoluzionali (CNN, Convolutional Neural Networks) associate al deep learning in combinazione con altre architetture come i Transformer per migliorare le prestazioni in vari ambiti. Come l’analisi approfondita di sequenze di testo come quelle necessarie per l’analisi del sentiment.

Ulteriore passo avanti è stato fatto con l’implementazione delle reti neurali profonde (DNN, Deep Neural Networks) che si rendono responsabili della generazione di modelli più potenti, versatili e adattabili.

Le librerie di Large Language Model sono una manna dal cielo per i programmatori. Forse l’utente finale non ne sentirà il bisogno ma i benefici li raccogliamo tutti i giorni. Infatti, stiamo parlando di strumenti organizzati e pensati per facilitare l’utilizzo, l’addestramento e l’implementazione dei LLM. In sintesi, queste sono le basi per gestire al meglio i grandi modelli di linguaggio, senza doverne creare uno da zero. Vuoi creare qualcosa partendo da un LLM? Puoi farlo grazie alle librerie di Large Language Model. Ecco le più importanti:

A tutto questo aggiungiamo suite dedicate all’intelligenza artificiale generativa come Google Cloud AI, OpenAI e altre piattaforme simili che continuano a rivoluzionare il settore, offrendo strumenti per le tue applicazioni AI. Da integrare in un flusso produttivo aziendale grazie al contributo di un’azienda specializzata.